A menudo se debate sobre el poder que han adquirido las grandes empresas tecnológicas, en un discurso que a veces puede parecer ajeno y lejano a los usuarios de a pie. Hablamos mucho de cómo pueden explotar nuestros datos y de los límites de la privacidad, pero no somos del todo conscientes de su impacto. Sin embargo, hay ejemplos en los que las medidas y decisiones que puedan tomar estos gigantes afectan directamente a las personas, con implicaciones que trascienden las pantallas.

Es lo que le ha sucedido a un padre que tomó fotos con fines médicos de las partes íntimas de su hijo, que tenía una infección. Al capturarlas, Google hizo una copia de seguridad, sincronizó las imágenes y, a través de sus medidas de escaneo y análisis, las identificó como material de abuso sexual infantil.

Google canceló su cuenta y todos los servicios asociados a ella y, a pesar de que tras ser investigado por la policía se concluyó que no se había producido un delito, la compañía se negó a devolverla, inhabilitando más de una década de información personal de correos electrónicos, archivos en la nube y teléfonos.

Este ejemplo pone de manifiesto cómo Google puede actuar de árbitro entre tu vida online y tu vida real, en la que ni siquiera agentes de poder como la policía o un Estado cambian su parecer. Para entender estas implicaciones, vamos a analizar qué ha pasado en esta situación, cómo actúan las empresas tecnológicas como Google y qué implica.

Dos padres han perdido sus cuentas e información de Google por tomar fotografías de sus hijos con fines médicos

La historia de este padre de Estados Unidos salió a la luz el 21 de agosto, cuando The New York Times reportó el caso. En la noticia se explica que el hombre tomó las fotos para hacer un seguimiento de la evolución del problema médico de su hijo pero, dos días después, le llegó una notificación: su cuenta había sido inhabilitada debido a la detección de un “contenido dañino” que suponía “una violación grave de las políticas de Google y podría ser ilegal”. En particular, entre la lista de motivos que se enlazaba se incluía “abuso y explotación sexual infantil”.

Pese a que este padre envió un formulario en el que solicitaba la revisión del caso, explicando que las fotos habían sido tomadas debido a una infección de su hijo, Google respondió que no reestablecería la cuenta. Debido a esta decisión, el hombre perdió diez años de información: su cuenta de email y sus correos electrónicos, documentación, todas sus fotos sincronizadas (incluyendo las de los primeros años de vida de su hijo) y hasta su número de teléfono, que tenía contratado con Google Fi (una compañía telefónica sólo disponible en Estados Unidos).

Meses más tarde, según narra The New York Times, el hombre fue notificado de que había sido investigado por la Policía de San Francisco, que había tenido acceso a toda su cuenta de Google: sus búsquedas en Internet, su historial de ubicación, sus mensajes y cualquier documento, foto y vídeo que hubiera almacenado. El caso se cerró concluyendo que “el incidente no cumplió con los elementos de un delito y que no ocurrió ningún delito”. El padre volvió a apelar a Google, informe policial en mano, pero tampoco recuperó su cuenta.

No es el único caso. El 22 de febrero de 2021, Google inhabilitó la cuenta de otro padre por haber violado gravemente sus políticas de uso. Misma historia: fotos íntimas de su hijo debido a una infección. El hombre lo explica en Quora y en The New York Times se recoge que, después de ser investigado por la policía y mostrarle las comunicaciones con el pediatra, fue absuelto. En resumen: a pesar de que la policía absolvió a ambos casos, Google no ha dado marcha atrás devolviéndoles sus cuentas.

Cómo escanea y decide Google qué contenido es material de abuso infantil

Desde Google afirman estar en lucha contra el abuso sexual infantil y con la prevención de su difusión en sus plataformas. “El material de abuso sexual infantil es aborrecible y estamos comprometidos a prevenir su difusión en nuestras plataformas. Seguimos la legislación estadounidense para definir lo que constituye material de abuso sexual infantil”, dice una portavoz de Google a Maldita.es.

Dentro de las políticas del programa sobre abusos y medidas por incumplimiento de las políticas de Google, se especifica que las medidas aplican al contenido publicado en Google Fotos y que, cuando reciben una notificación sobre una posible infracción de las políticas, podrán revisar el contenido y “tomar las medidas que estimemos oportunas, como, por ejemplo, restringir el acceso al contenido, eliminar el contenido, rechazar imprimir el contenido y limitar o cancelar el acceso de un usuario a los productos de Google”.

También se añade que retirarán el contenido relacionado con sexualización de menores de edad (el CSAM, de child sexual abuse material, material de abuso sexual de menores en inglés) “tomando las medidas necesarias, entre las que se incluyen denunciarlo al centro para menores desaparecidos y explotados de Estados Unidos [NCMEC, por sus siglas en inglés, National Center for Missing & Exploited Children], limitar el acceso a las funciones de productos e inhabilitar cuentas”.

Pero, ¿cómo decide Google qué es material de abuso infantil y qué no para identificarlo y, en caso afirmativo, eliminarlo? En el proceso de detección de imágenes de abuso sexual de menores, Google detalla a Maldita.es que utilizan una combinación de dos tecnologías: hash matching (coincidencia hash de imagen) e inteligencia artificial (IA).

Como hemos explicado previamente, el proceso hash consiste en una etiqueta formada por una secuencia aleatoria de caracteres creada por un algoritmo que se asocia a cada imagen en función de la cantidad de píxeles, los colores y su disposición. De esta manera, esta tecnología asigna a las imágenes y videos una especie de etiqueta digital única y luego la compara con una base de datos de etiquetas conocidas; en este caso, buscaría similitudes entre imágenes etiquetadas como contenido sexual de menores.

Si dos hashes coinciden, se considera que el contenido es el mismo o muy similar. Desde Google indican que obtienen los hashes de una variedad de fuentes “altamente confiables”, incluidas la Internet Watch Foundation y el Centro Nacional para Niños Desaparecidos y Explotados (NCMEC, por sus siglas en inglés).

Cuando un hash se confirma como material de abuso sexual de menores, Google lo introduce en sus modelos de detección, donde se usa inteligencia artificial “para marcar contenido nuevo que es muy similar a los patrones de CSAM confirmados anteriormente”. Esta IA está entrenada a partir de la base de datos de CSAM conocidos, así como imágenes que no consideran CSAM, “lo que garantiza la precisión y el control de calidad para enseñar a nuestros sistemas a reconocer lo que es y no es CSAM y nos ayuda a mantener una tasa de detección de falsos positivos muy baja”.

Hash, inteligencia artificial… ¿Y la revisión humana? En este punto dice Google que entra un moderador de contenido, que revisa las fotos después de que la inteligencia artificial las haya marcado para confirmar que cumplen “con la definición federal de material de abuso sexual infantil”. Sí es así, es entonces cuando Google bloquea la cuenta del usuario, busca si hay más contenidos similares y hace un informe al NCMEC.

¿Y en el caso en que las imágenes puedan ser material con fines médicos? “Nuestro equipo de expertos en seguridad infantil revisa el contenido marcado para comprobar su exactitud y consulta con pediatras para ayudar a asegurar que somos capaces de identificar los casos en los que los usuarios pueden estar buscando consejo médico”, asegura la portavoz de Google a Maldita.es.

Qué ha dicho Google sobre no devolver las cuentas bloqueadas cuando se ha demostrado que no hubo delito

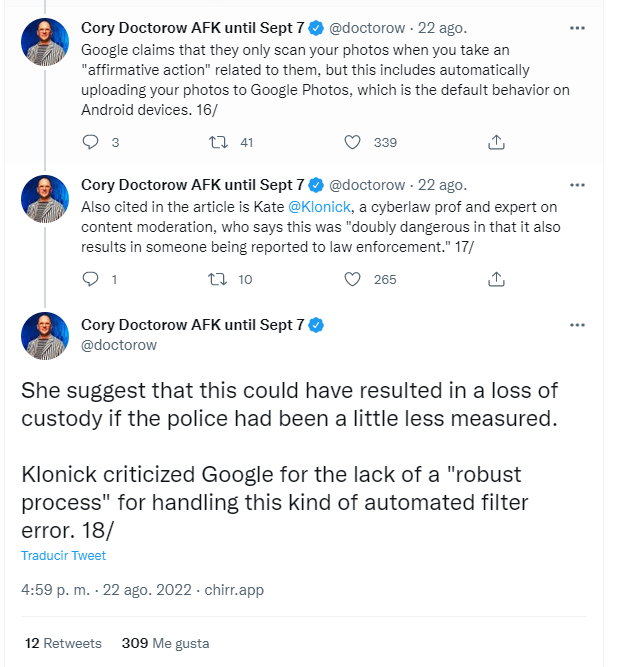

Si se ha demostrado que el material no era delictivo, como en el caso de estos padres, ¿por qué Google no da marcha atrás y devuelve el acceso a toda esa información? En Twitter, muchos usuarios recogían opiniones al respecto. “¿Qué tal si las big tech compensan el impacto de la restricción automática errónea del acceso a las cuentas'?”, se preguntaba una tuitera que publica sobre privacidad y protección de datos. “Una de las cosas que me preocupa aquí es que Google se niega a devolverle la cuenta al padre”, expresaba una experta en seguridad digital.

Preguntamos a la compañía en qué se apoya para seguir bloqueando una cuenta ante una casuística así, en la que la investigación policial demuestra que no hay delito cometido, a lo que Google respondió que no podían compartir información específica dada la naturaleza “sensible” de este caso. Insisten, no obstante, en que siguen “la definición legal de EEUU sobre qué es considerado material de abuso sexual de menores” por lo que están “legalmente obligados a informar sobre contenido identificado como CSAM; subir o compartir este contenido es una violación de nuestros Términos de servicio”.

No contestaron a nuestras preguntas sobre el proceso interno que siguen para decidir si se desbloquea o no una cuenta, sino que recordaron que los usuarios tienen la capacidad de apelar las decisiones que toma la empresa.

En el caso reciente del padre acusado que recoge The New York Times, Google no dio explicaciones más allá de decir que no recuperaría su cuenta. Al padre que reportó su caso en Quora, después de apelar también a través un formulario de revisión, Google también le negó la recuperación con este email:

“Hemos revisado su solicitud relativa a su cuenta [email protected] y hemos confirmado que ha infringido nuestras Condiciones de Servicio. Por lo tanto, no restableceremos su cuenta.

Por favor, consulte nuestras Condiciones de Servicio para obtener más información sobre nuestras políticas y las acciones que tomamos en respuesta a las violaciones de las políticas en nuestros productos.

El Equipo Google”.

Las implicaciones de que bloqueen y borren tu vida online

¿Qué implicaciones tiene que Google bloquee el acceso a absolutamente todos sus servicios a una persona? Que pierde su vida online (y lo que eso conlleva en la offline). Como detalla el propio Google, todos sus servicios se suspenden y su información se inhabilita.

Pensemos en los miles de datos que conferimos a una gran tecnológica como Google. Con la sincronización del móvil, guardamos todos nuestros contactos telefónicos, nuestros mensajes y llamadas, y toda la información de nuestro teléfono. En Gmail, almacenamos gigas y gigas de correos electrónicos, lo que incluye direcciones, información que puede ser relevante para nosotros, comunicaciones relacionadas con trabajo, eventos personales… En Drive, tenemos un cajón (a menudo, de sastre) en el que guardamos absolutamente todo: las fotografías de nuestros viajes, documentos laborales, facturas, contratos de vivienda… ¿Dónde guardamos las copias de seguridad de todos nuestros datos? Efectivamente, en sitios como Google. Y todo esto, desde que tengas una cuenta ahí, probablemente varios años.

Y no solo eso: nuestro correo y nuestro teléfono son nuestra puerta de entrada de seguridad a otras aplicaciones y cuentas de Internet. ¿Para acceder a Twitter? “Revise el email que le hemos mandado a su correo electrónico.” ¿Una compra online? “Inserte el código que le ha llegado a su móvil”. ¿Se ha bloqueado tu cuenta de Facebook? “Pinche en el enlace de autenticación que recibirá en su teléfono”. El bloqueo de nuestra vida digital puede ser total.

El peligro de perder todo eso no enlaza tanto de nuestra dependencia a las tecnológicas: la vida online hay que vivirla en algún sitio, y por eso en Maldita.es te contamos cómo hacerlo de la forma más segura y mantenemos al día de los cambios que puedan afectarte para que puedas tomar tus propias decisiones.

En este caso, se pone de relieve el papel de esta empresa en una situación cotidiana como puede ser una consulta de telemedicina que termina convirtiéndose en un quebradero de cabeza que ni la policía puede solventar. La profesora de derecho cibernético y experta en moderación de contenido Kate Klonick alertaba de que incluso una situación así, mal gestionada podría haber acabado en una pérdida de la custodia de los niños, como se recogía en un análisis en Twitter de lo sucedido.

“Estas compañías siguieron deliberadamente una estrategia para convertirse en indispensables para nosotros con la excusa de organizar la información del mundo”, relata Cory Doctorow, asesor de la Electronic Frontier Foundation (EFF). “Sin embargo, se comportan continuamente como si fueran simplemente otro negocio cuyos imperativos comerciales -incluyendo la cancelación arbitraria de tus servicios sin apelación posible- fueran cuestiones de privacidad”.

Además, hay diferencias en la naturaleza de las imágenes según la plataforma. No es lo mismo publicar una fotografía en Facebook o Instagram, que tener imágenes privadas en tu móvil en Apple o Google. De hecho, en 2021, Apple hizo una tentativa para incluir un sistema de rastreo para buscar pornografía infantil en las imágenes almacenadas en los dispositivos de la marca. Como te contamos en Maldita.es, numerosos expertos en datos personales y asociaciones de derechos digitales criticaron la medida al considerar que abre la puerta a la vigilancia del usuario, y finalmente Apple decidió retrasar su puesta en marcha.

En los servicios que ofrece Google u otras grandes tecnológicas tenemos nuestra vida online al alcance de un clic, sí, pero también hay que ser conscientes de que también tienen ellos al alcance de otro clic quitárnosla.