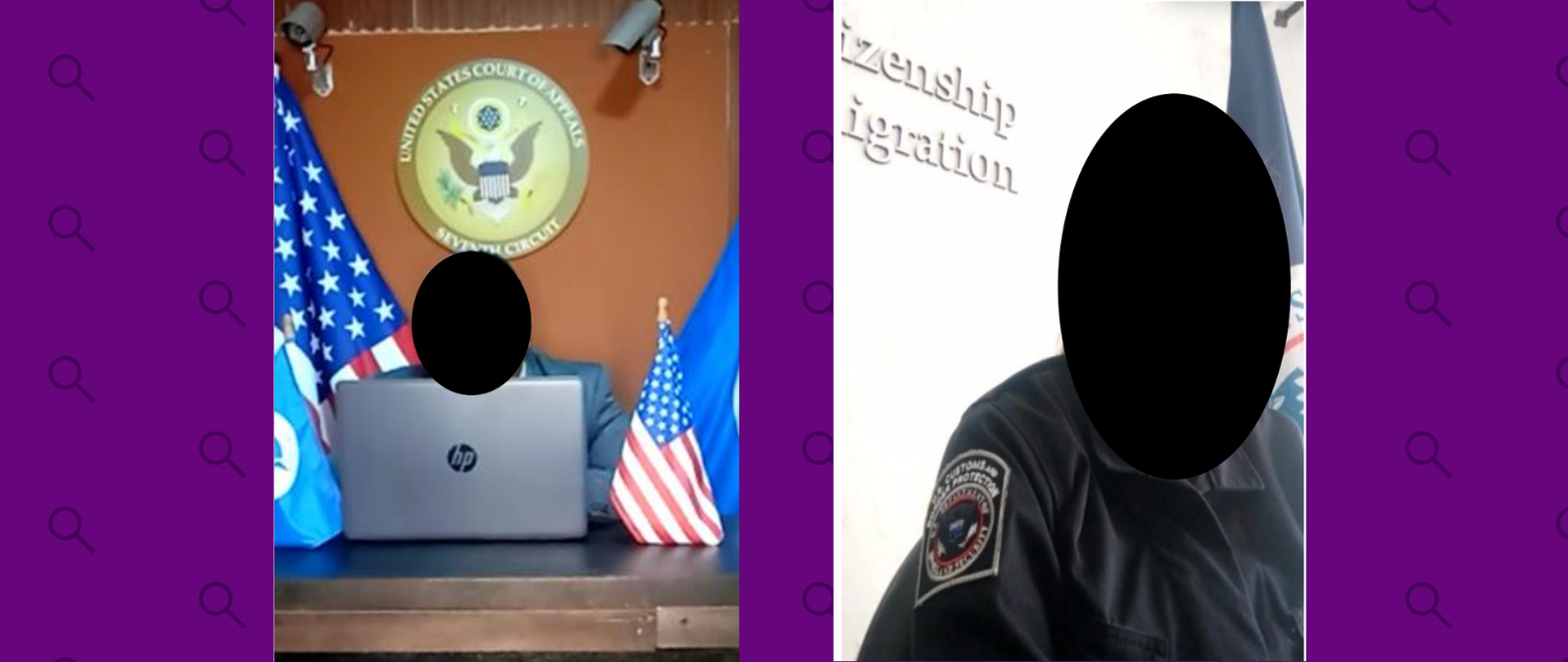

A primera vista, Alex puede parecer un presentador de noticias convencional de un canal de televisión. Pero, al visualizar el video en el que aparece, hay algo que llama la atención: su voz parece acartonada y no se sincroniza con el movimiento de su boca. Alex no es una persona de verdad. Es un avatar generado por computadora con un programa de inteligencia artificial.

A finales del año pasado, cuentas bot que promueven los intereses del Partido Comunista Chino distribuyeron videos de Alex y otra presentadora de noticias ficticia en Facebook y Twitter, según Graphika, una empresa de investigación que estudia la desinformación. Sus investigadores explican que se trata del primer caso conocido en el que se usa tecnología deepfake para producir personas ficticias como parte de una campaña de información alineada a un Estado.

@factchequeado Presentadores ficticios, inteligencia artificial… presta atención a estos deepfakes👆🏽

♬ Paradise - Ben Fox

¿Qué son los deepfakes?

Los deepfakes son videos manipulados o generados sintéticamente con tecnología basada en inteligencia artificial con el objetivo de crear imágenes falsas realistas. En ellos, suelen aparecer rostros, cuerpos o voces humanas que pueden parecer auténticas y naturales.

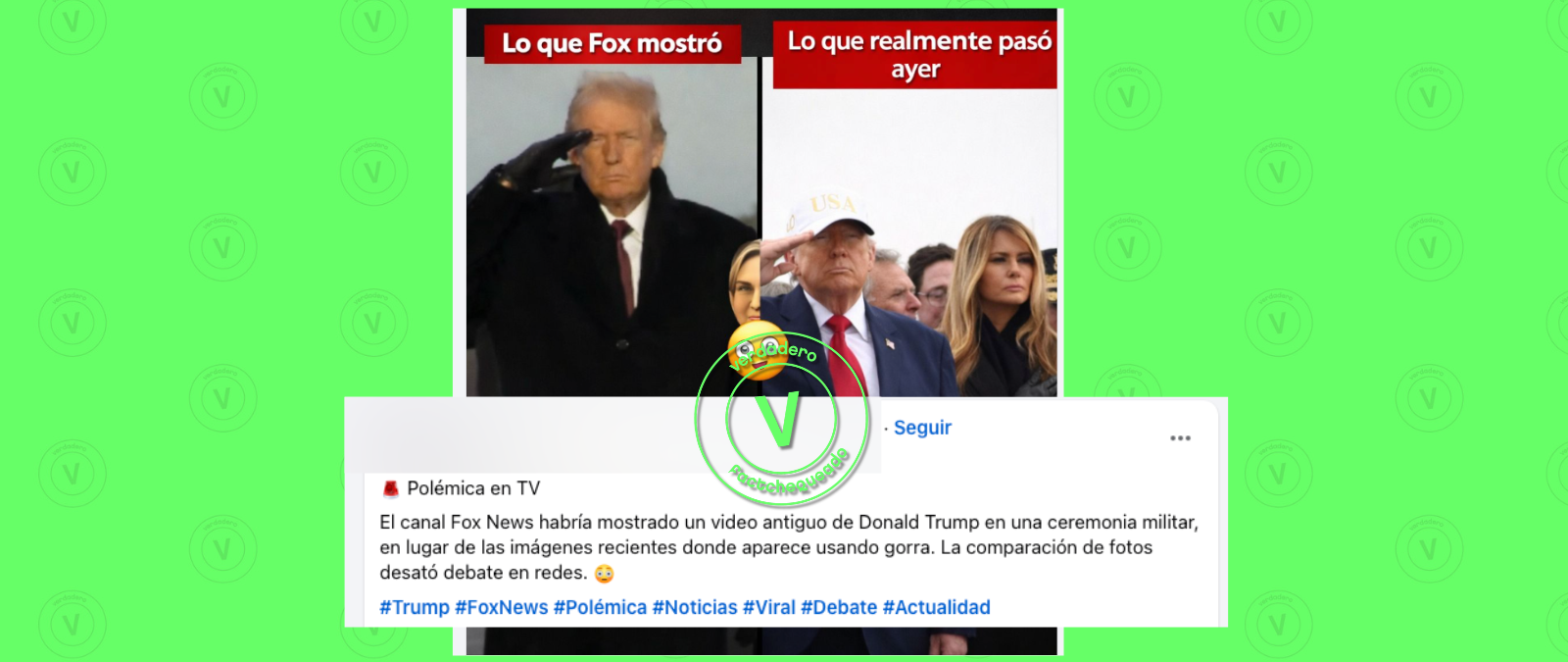

En redes sociales normalmente circulan deepfakes de famosos o rostros conocidos. Por ejemplo, del presidente de Ucrania, Volodímir Zelenski; de Elon Musk, el dueño de Twitter; o de la cantante española Lola Flores, que falleció en 1995. En los últimos días también se ha compartido en Twitter un deepfake en el que el presidente de Estados Unidos, Joe Biden, supuestamente anuncia que “un número de objetos voladores no identificados han aparecido en muchas partes de nuestro país” y que el FBI le ha informado que “es muy posible” que “estos visitantes” sean “de naturaleza extraterrestre”. Pero en este caso se trata de un deepfake de gente ficticia, por lo que puede ser más difícil de detectar.

¿Qué sabemos sobre esos presentadores de noticias ficticios?

Los 2 videos en los que aparecen presentadores ficticios, que supuestamente trabajan para un canal llamado Wolf News, promueven los intereses del Partido Comunista Chino, según destacan desde Graphika.

En uno de ellos, se critica una falta de acción del gobierno de Estados Unidos contra la violencia armada. En el otro, se enfatiza en el papel de China en las relaciones geopolíticas durante una cumbre internacional.

Graphika ha relacionado a los 2 falsos presentadores con la tecnología de Synthesia, una empresa que genera videos “sin cámaras, micrófonos ni estudios”. “La creación de videos con inteligencia artificial es una alternativa rentable a los complejos y costosos procesos tradicionales de creación de videos”, afirma la compañía.

Jack Stubbs, vicepresidente de inteligencia de Graphika, explica al periódico The New York Times que algunos de estos softwares de inteligencia artificial como Synthesia permiten crear videos en cuestión de minutos. * Según cuenta, pueden adquirirse fácilmente en Internet y sus suscripciones cuestan a partir de unos pocos dólares al mes, lo que “facilita la producción de contenidos a escala”.

De hecho, en las últimas semanas Graphika ha detectado a otros usuarios que usan las mismas tácticas, en países como Burkina Faso. La organización venezolana Cazadores de Fake News también ha detectado el uso de este tipo de avatares “en la propaganda venezolana”.

Héctor Mazarri, de Cazadores de Fake News, explica al periódico El País que se trata de “un intento organizado para impulsar ciertas narrativas favorables al Gobierno”. “Aunque un usuario entrenado puede darse cuenta de los errores, esto está hecho para que nadie esté exento de no creerlo”, señala.

¿Dónde estamos viendo deepfakes sin ser conscientes?

“Cuando vemos deepfakes en informativos aparecen solamente para alertarnos de sus peligros; y cuando los vemos en programas, el acabado es malo, 'de andar por casa'. Se hace adrede para que el público entienda lo que es y sólo se emplee con fin humorístico o paródico”, explica Graciela Padilla Castillo, autora del estudio “Alfabetización moral digital para la detección de deepfakes y fakes audiovisuales”, a Maldita.es, medio cofundador de Factchequeado.com.

En realidad, donde sí hemos visto que esta tecnología se usa y es efectiva es en otros ámbitos: especialmente el del cine y también en la pornografía. Varias creadoras de contenido han denunciado el uso de deepfakes sexuales no consentidos. En Maldita.es explican cómo esta tecnología se usa sin el consentimiento de las víctimas (la mayoría, mujeres famosas) en el porno.

Fijarse bien en el rostro y otros consejos para detectar un deepfake

En el ámbito de la desinformación, esta técnica es muy atractiva para los que la diseminan. Imagínate, por ejemplo, el desconcierto que causaría en la opinión pública ver a un político diciendo algo totalmente disparatado o contrario a sus ideales.

Formar a la ciudadanía para detectar la manipulación del discurso público es indispensable para prevenir caer en estas trampas, ya que suponen la misma amenaza que otros tipos de desinformación.

@factchequeado 5 consejos para detectar un deepfake.

♬ News serious information news program - gooooodee_jay

Para detectar un deepfake, el MIT Media Lab, un laboratorio dentro de la Escuela de Arquitectura y Planificación en el Instituto de Tecnología de Massachusetts, aconseja prestar atención a la cara de quien aparece en el video y hacerse algunas preguntas como estas: “¿La piel parece demasiado suave o demasiado arrugada? ¿El envejecimiento de la piel es similar al del cabello y los ojos?”.

También recomienda fijarse en los ojos, las cejas y las gafas. Por ejemplo, si aparecen sombras en los lugares esperados, si la persona parpadea demasiado o muy poco o si cambia el ángulo del resplandor en los cristales de las lentes cuando la persona se mueve.

Además de observar los movimientos de los labios y en si se sincronizan con la voz, el MIT Media Lab también sugiere prestar atención al vello facial o a la falta del mismo. “¿Parece real? Los deepfakes pueden agregar o quitar bigote, patillas o barba. Pero pueden no lograr que las transformaciones del vello facial sean completamente naturales”, destaca.

Si estos videos son de personas famosas a las que estamos acostumbrados a oír, Graciela Padilla, docente y autora de varios estudios al respecto, aconseja fijarse en los ritmos, vicios o muletillas naturales en la forma de hablar.

Leer más:

Factchequeado es un medio de verificación que construye una comunidad hispanohablante para contrarrestar la desinformación en Estados Unidos. ¿Quieres ser parte? Súmate y verifica los contenidos que recibes enviándolos a nuestro WhatsApp +16468736087 o a factchequeado.com/whatsapp.

* Actualizado el 24 de febrero con el nombre completo y el cargo de Jack Stubbs, vicepresidente de inteligencia de Graphika.