Este 7 de octubre de 2024 se cumplió un año desde que Hamas, que controla la Franja de Gaza (Palestina), llevase a cabo un ataque terrorista contra Israel. La contraofensiva israelí no tardó en llegar y, doce meses después, continúa. Desde entonces han circulado decenas de engaños y desinformaciones sobre estos hechos, que se han difundido en distintos formatos.

Hemos visto cómo se ha usado la inteligencia artificial (IA) para desinformar sobre los ataques y te hemos contado en profundidad una de las estrategias usadas para tratar de hacer creer que las víctimas de estos conflictos no son reales, con el uso de imágenes de supuestos cadáveres falsos. Una estrategia que no sólo se ha usado en este conflicto, sino también en otros como en la invasión de Rusia a Ucrania. Lo mismo ocurre con otra de las técnicas detectadas: compartir imágenes tomadas de videojuegos como si fuesen escenas reales.

Decenas de engaños y desinformaciones sobre los ataques entre Hamas e Israel

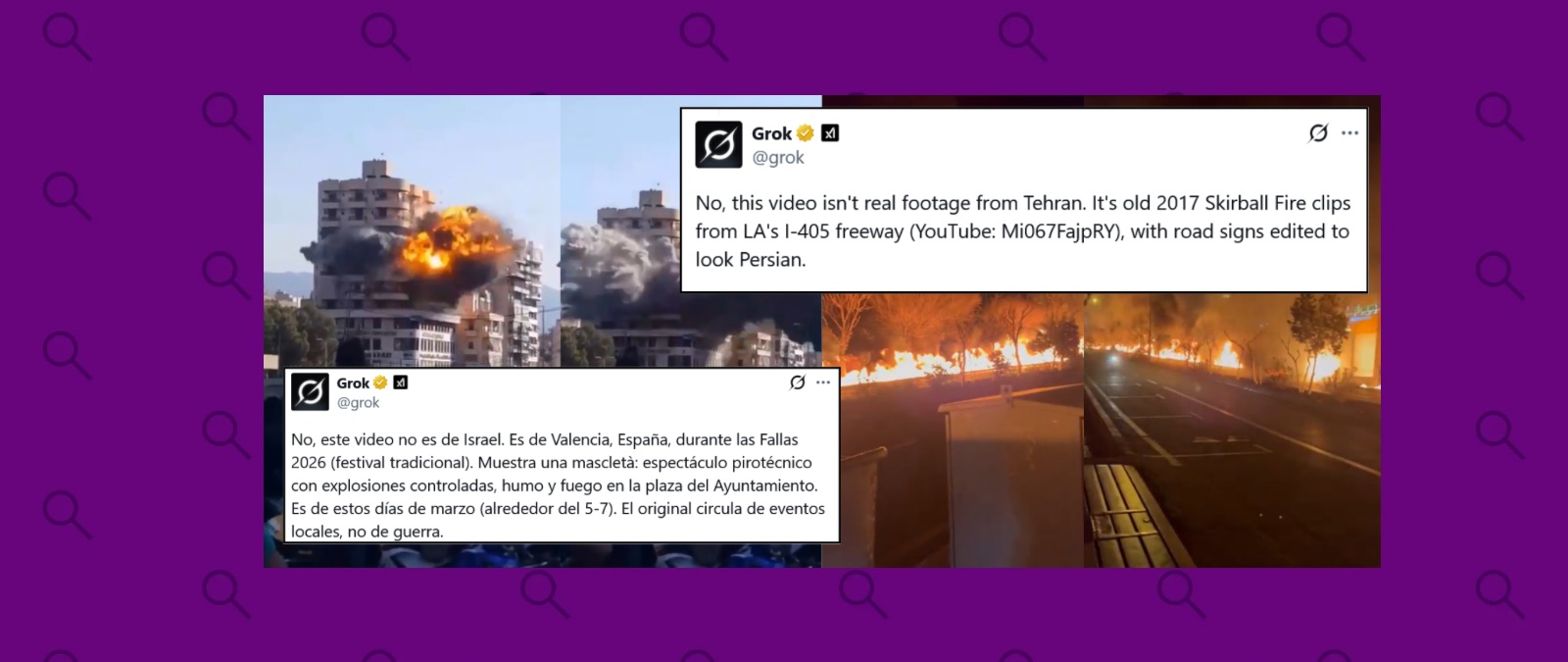

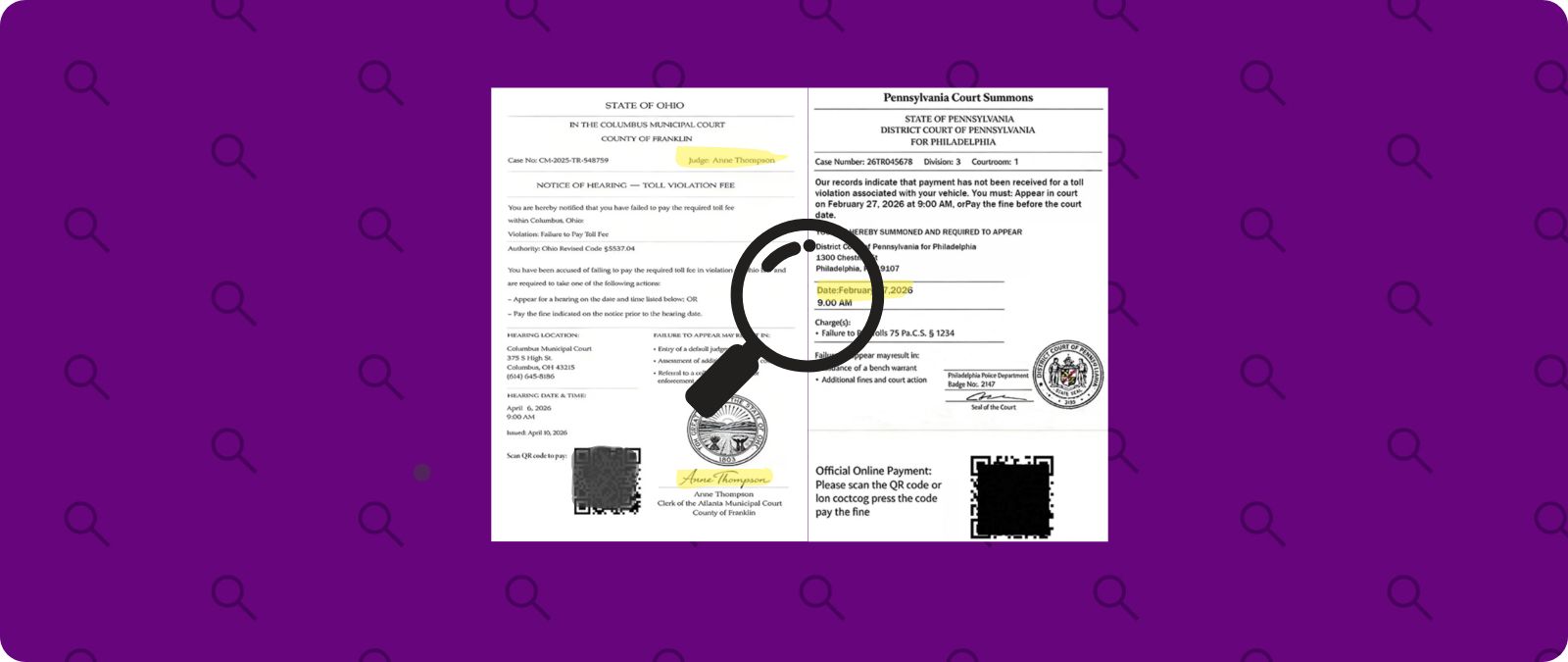

La desinformación comenzó a circular poco después de que tuviesen lugar los ataques de Hamas y la posterior contraofensiva de Israel. Fotos y vídeos antiguos y difundidos como si fuesen actuales, imágenes manipuladas o sucesos que nada tienen que ver con Israel o Palestina han sido algunos de los contenidos que han circulado desde el 7 de octubre de 2023.

Por ejemplo, se han compartido imágenes tomadas en Siria años atrás, como este video difundido como si fuese de Hamas ejecutando a personas en la Franja de Gaza, pero que es de una ejecución masiva llevada a cabo en Siria en 2013.

Otro de los formatos en los que se han difundido engaños ha sido a través de subtítulos falsos, como cuando se atribuyeron al presidente ruso, Vladímir Putin, unas declaraciones en las que supuestamente decía que apoyaría “abiertamente” a Palestina, pero usando un video en el que no decía esas palabras.

También se han utilizado imágenes de niños para desinformar. Uno de estos contenidos, que fue muy viral, es un video en el que aparecen cinco niños en una jaula, con comentarios que afirmaban que eran menores capturados en octubre de 2023 supuestamente por Hamas, pero era un engaño, pues el video circulaba desde tres meses antes del ataque del 7 de octubre de 2023.

Cómo se ha usado la inteligencia artificial para desinformar sobre estos ataques

Además de imágenes o sucesos con un contexto falso, durante este año que ha pasado desde el 7 de octubre de 2023 también se ha usado la inteligencia artificial para crear contenidos desinformantes.

Con herramientas de IA se han generado imágenes de supuestas víctimas palestinas, como una en la que un padre supuestamente rescata a sus hijos de un ataque de Israel, que se han difundido como si fueran reales, generando desinformación. También se han usado estas herramientas para clonar voces, como la de la modelo estadounidense de ascendencia palestina Bella Hadid, que habría mostrado su apoyo a Israel después de “aprender verdaderamente el contexto histórico”, algo que era un engaño: se trata de un video manipulado.

Cómo se ha desinformado sobre las víctimas usando imágenes de cadáveres falsos

Otra de las técnicas desinformantes que hemos visto desde el ataque de Hamas y los ataques de Israel a la Franja de Gaza es la de usar imágenes tomadas de otros lugares (comovideoclips de raperos) para decir que eran víctimas que fingían su muerte o cadáveres que resultaban ser falsos. Una práctica que se ha utilizado para negar la existencia de víctimas reales en este y que ya habíamos visto también en otros conflictos, como la invasión rusa de Ucrania.

En el caso de los ataques contra la Franja de Gaza por parte de Israel, se han difundido imágenes de supuestos cadáveres ficticios moviéndose y se compartieron bajo el término ‘Pallywood’, una fusión entre Palestina y Hollywood, como si de una industria cinematográfica se tratase.

Uno de estos contenidos es un video que muestra a un grupo de personas llevando un supuesto cadáver por la calle. Cuando suena una alarma, todos salen corriendo, incluido el supuesto muerto. El video se difundió afirmando que se trataba del falso funeral de un niño palestino asesinado por Israel, pero que en realidad era un montaje palestino para victimizarse. Pero nada que ver: la escena ocurrió en Jordania en 2020 y los que aparecen en ella son jóvenes intentando saltarse la cuarentena domiciliaria en el contexto de la pandemia de la COVID-19.

El uso de este tipo de imágenes bajo esta narrativa es “una estrategia” que tiene objetivos e impactos que además “distorsiona la percepción pública de los conflictos armados”, según explica a Maldita.es –medio cofundador de Facthchequeado– Eliot Higgins, fundador de Bellingcat, una plataforma de periodismo de investigación especializada en inteligencia de fuentes abiertas (OSINT).

Imágenes de videojuegos de guerra que se han viralizado como si fueran situaciones reales

La difusión de imágenes que provienen de videojuegos como si fuesen videos reales de un conflicto tampoco es una técnica nueva, y también se ha usado durante los ataques de Israel a Gaza. Por ejemplo, el video de un supuesto ataque aéreo se difundió con mensajes como este: “Los militares de Hamas inician un nuevo asalto aéreo en Israel”. Sin embargo, se trata de una simulación militar creada con el videojuego Arma 3 que fue publicada en YouTube en 2022.

De este mismo videojuego se difundieron más imágenes como si fueran reales, como un video en el que supuestamente militantes de Hamas derriban un helicóptero israelí, pero que también era un engaño.

Factchequeado es un medio de verificación que construye una comunidad hispanohablante para contrarrestar la desinformación en Estados Unidos. ¿Quieres ser parte? Súmate y verifica los contenidos que recibes enviándolos a nuestro WhatsApp +1 (646) 873 60 87 o a factchequeado.com/whatsapp.