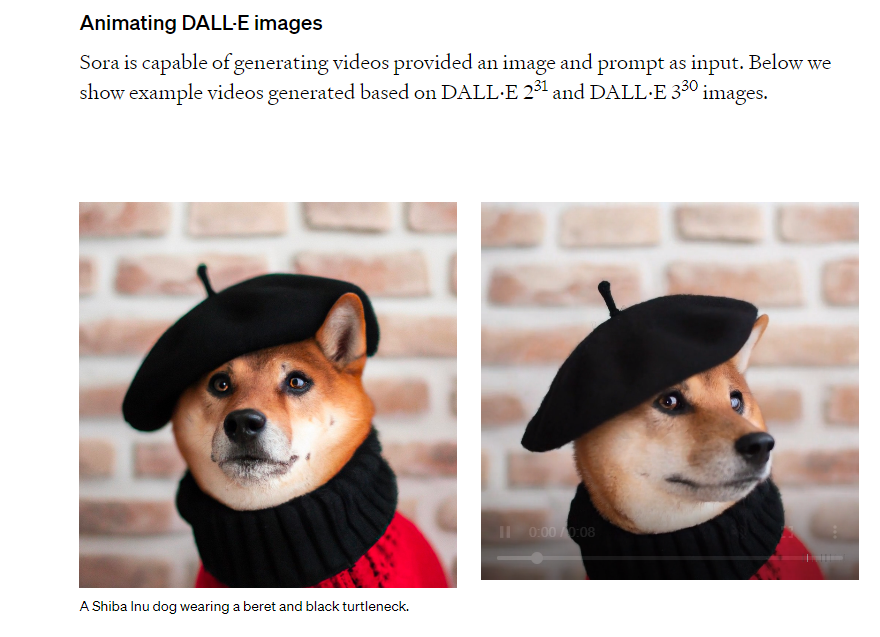

Después de la explosión de la IA generativa de imágenes a finales de 2022 y 2023, varios análisis pronosticaban que en 2024 le llegaba el turno al video. Hasta ahora, las herramientas de generación de video con IA disponibles para el público devolvían resultados limitados, pero el 15 de febrero de 2024 OpenAI (empresa responsable de ChatGPT y DALL-E) presentó Sora, una herramienta que permite generar videos a partir de instrucciones de texto (los conocidos como prompts) y fotografías.

Con esta aplicación se pueden crear videos desde cero o animar imágenes ya existentes. Sus resultados han sorprendido y generado reacciones en redes sociales, pero de momento tiene limitaciones y su uso está restringido a expertos. Como pasa con este tipo de tecnologías, surgen las preguntas sobre cómo se puede usar de manera fraudulenta o para difundir desinformación. Explicamos qué sabemos de Sora hasta ahora.

¿Qué es Sora? ¿Cómo funciona?

Sora es una aplicación de generación de video que está desarrollando OpenAI, la empresa dueña, entre otros, de ChatGPT, que permite crear imágenes en movimiento a partir de instrucciones de texto, de fotografías o de otros videos. Para la primera opción, podemos introducir la descripción de una mujer caminando por las calles de Tokio o de un joven leyendo un libro encima de una nube, y la aplicación generará un pequeño fragmento de video que cumpla con estas características.

Prompt: “A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. she wears a black leather jacket, a long red dress, and black boots, and carries a black purse. she wears sunglasses and red lipstick. she walks confidently and casually.… pic.twitter.com/cjIdgYFaWq

— OpenAI (@OpenAI) February 15, 2024

También es capaz de animar una imagen estática o de alargar un video que ya haya sido grabado, aseguran sus creadores en la web.

¿Cómo es capaz de generar imágenes en movimiento? ¿En qué se diferencia de DALL-E?

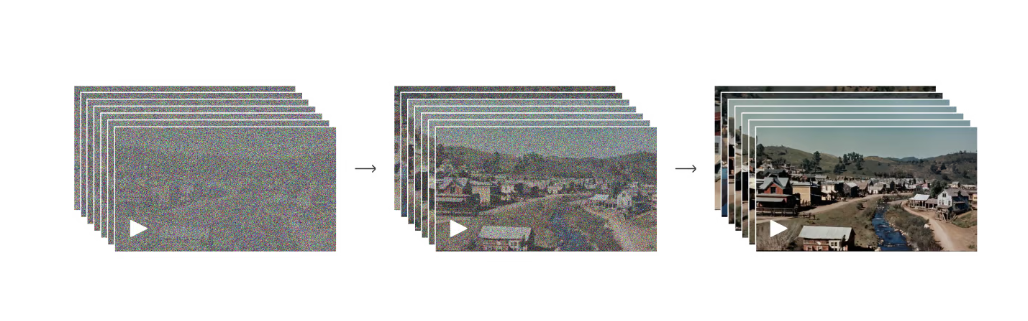

Sora, al igual que DALL-E (otra herramienta de la misma empresa), es un modelo de difusión: un programa entrenado para relacionar los patrones de una imagen a determinadas palabras y poder reconstruirlas. Gracias a este proceso es capaz de generar una imagen según una descripción de texto, como un poblado del salvaje oeste.

Generación de un fragmento de video a través de Sora. Fuente: OpenAI.

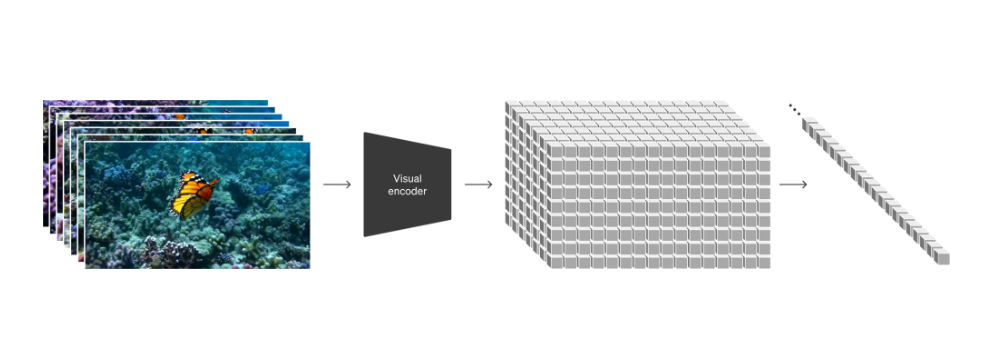

La diferencia con otras herramientas de imagen es que Sora, en lugar de procesar tokens (representaciones numéricas de fragmentos de una palabra o una imagen), emplea lo que se conocen como patches: fragmentos de video que incluyen información como la duración y el movimiento de los píxeles que aparecen en pantalla.

Extracción de los ‘patches’ de una imagen a través de Sora. Fuente: OpenAI.

Al analizar no sólo la información sobre los colores o los patrones de una fotografía, sino cómo los elementos de un video cambian de posición en un determinado periodo de tiempo, el programa es capaz de recrear imágenes en movimiento. En este artículo puedes encontrar más información sobre cómo funciona Sora y en qué consisten los patches.

¿Quién puede usar Sora? ¿Está disponible para el público?

Por ahora Sora no está disponible para el público y no hay ninguna fecha anunciada para su lanzamiento oficial. Según OpenAI, han compartido los avances de esta herramienta para “brindarle al público una idea de las capacidades de la inteligencia artificial que hay en el horizonte”.

Por el momento sólo tienen acceso a esta herramienta determinados investigadores y profesionales seleccionados por OpenAI para estudiar sus riesgos y las amenazas que pueden suponer para áreas como la desinformación, sesgos o el discurso de odio. La compañía asegura que también ha otorgado acceso a algunos artistas y expertos en audiovisuales para estudiar cómo se puede implementar esta herramienta dentro de la industria creativa.

¿Qué limitaciones tiene, qué errores comete?

Aunque Sora no está disponible para el público general, OpenAI ha detallado que de momento cuenta con algunas limitaciones. La primera de ellas es que sólo puede generar videos de un minuto de duración y se limita al apartado visual, estas imágenes no van acompañadas de audio.

Otras limitaciones tienen que ver con la física y la colisión de los elementos que aparecen en los videos. Por ejemplo, es incapaz de recrear la caída de un vaso al suelo, tiene dificultades para mostrar la interacción de personas y objetos entre sí, y, en ocasiones, se pueden superponer los elementos en pantalla, como pasa en este ejemplo con los animales.

Fuente: OpenAI.

Esta herramienta también tiene problemas para entender la dirección de algunos movimientos (puede confundir adelante con hacia atrás) y para seguir el movimiento de la cámara. Algunos videos muestran más errores que otros, como este video difundido por Sam Altman, CEO de la compañía, en el que los personajes van hacia atrás y se superponen entre ellos.

https://t.co/WJQCMEH9QG pic.twitter.com/Qa51e18Vph

— Sam Altman (@sama) February 15, 2024

¿Hay medidas para evitar que esta aplicación se use para generar contenidos violentos, sexuales o que suplanten la identidad de personas?

Los expertos advierten del riesgo que podría suponer una herramienta así para la difusión de deepfakes (videos hiperrealistas creados con IA) y algunos usuarios en redes sociales señalan que se podrían usar para generar contenidos sexuales sin el consentimiento de las víctimas, algo que ya está pasando con otras herramientas de IA.

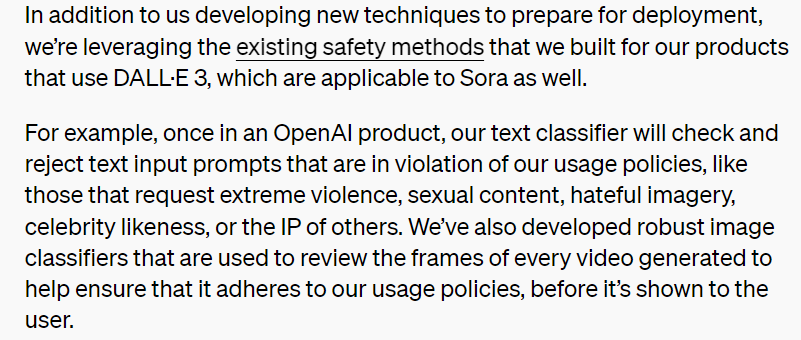

OpenAI ha asegurado que Sora cuenta con mecanismos de protección que impiden la generación de contenidos violentos, sexuales o que suplanten la identidad de famosos sin su consentimiento. Según la compañía, la aplicación contará con el mismo sistema que DALL-E para rechazar las instrucciones que puedan violar las políticas de uso. Pero investigaciones anteriores muestran que hay formas de usar los prompts para saltarse estas medidas de seguridad y obtener resultados fraudulentos e indebidos.

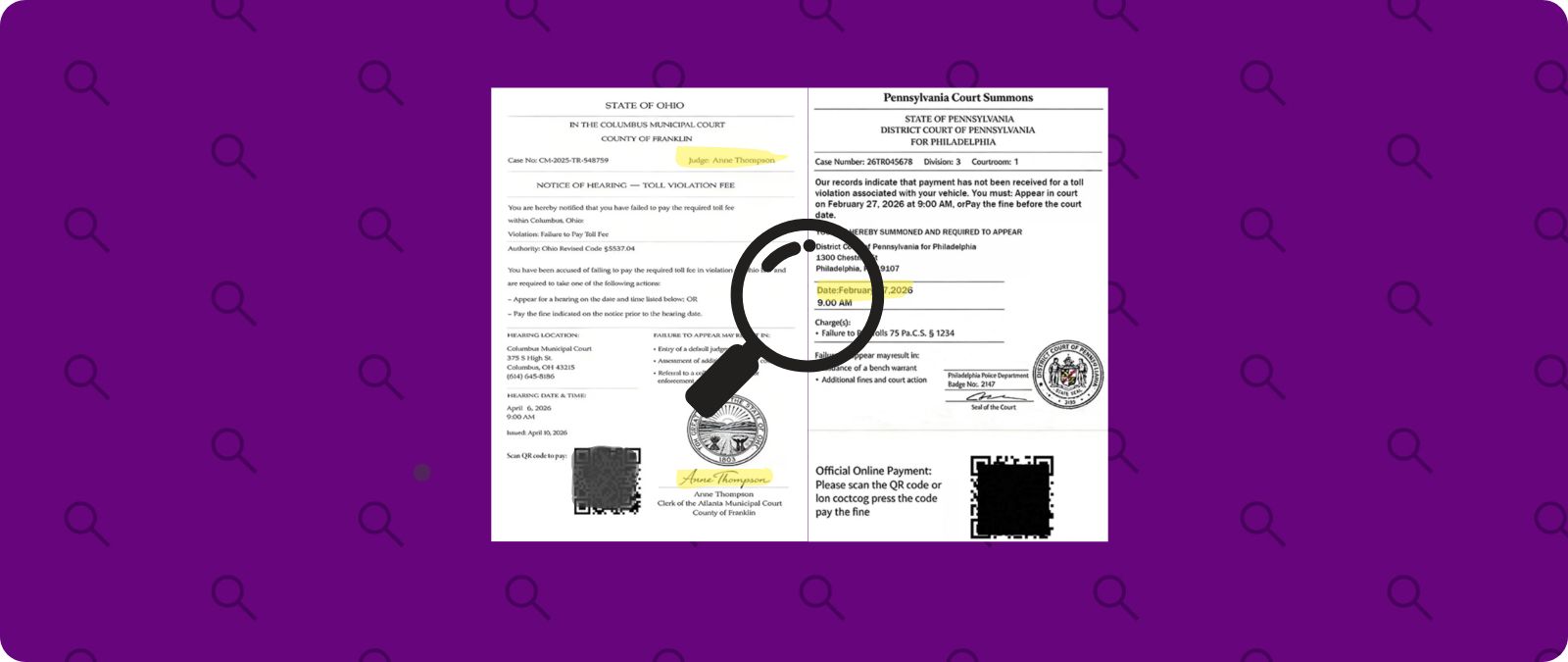

OpenAI argumenta que revisará cada fotograma de los videos que genere Sora antes de mostrarlos al usuario, pero no da más información sobre cómo funcionará este sistema y, al no haber sido lanzado al público, no se ha podido comprobar su eficacia por el momento. También está el riesgo de que este tipo de herramientas desarrollen sesgos o se puedan usar de forma fraudulenta para cometer estafas.

OpenAI asegura que Sora cuenta con las mismas restricciones que DALL-E para evitar usos fraudulentos de esta aplicación. Fuente: OpenAI.

La compañía también ha destacado que en un futuro se implementarán protocolos que adopte la Coalición para la Procedencia y Autenticidad de Contenido (C2PA, por sus siglas en inglés), como un certificado que permita verificar el origen de un video creado con Sora. Otras herramientas como las marcas de agua proponen una idea similar, pero no son una solución definitiva.

¿Puede afectar la IA generativa de video a la desinformación?

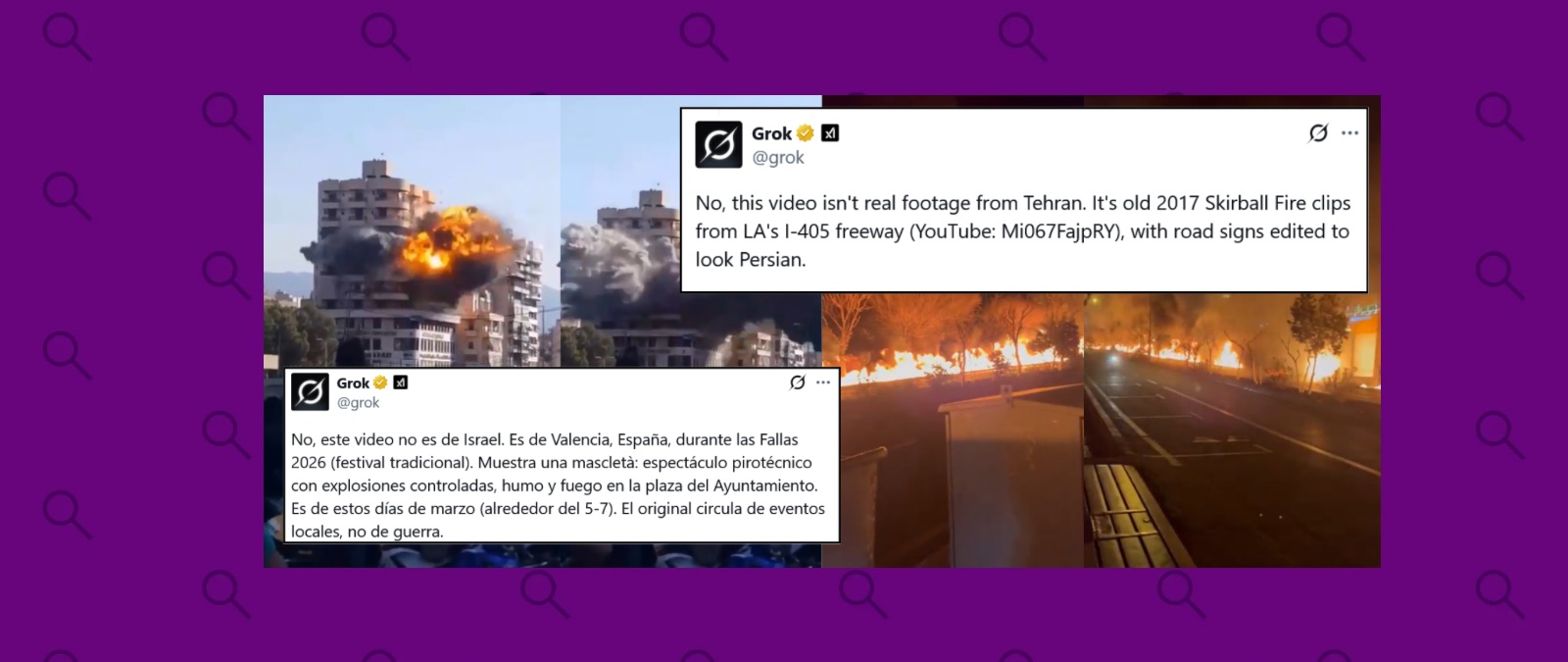

Las imágenes y los videos pueden ser una gran fuente de desinformación si se manipulan o se comparten sin el contexto correspondiente. Lo comprobamos a diario con las desinformaciones que se viralizan en relación a la invasión rusa a Ucrania, la pandemia de la COVID-19 o cualquier otro tema. Esto ya pasaba antes de que se popularizara la IA generativa, pero esta tecnología supone una herramienta nueva para generar contenidos que pueden desinformar.

Lo hemos visto con la democratización de las herramientas de generación de imágenes con IA: en Factchequeado hemos desmentido desinformaciones sobre el papa Francisco, políticos o activistas que se difundían como imágenes reales, pero eran generadas con IA. También para desinformar sobre los ataques entre Hamás e Israel. En el caso del video, lo hemos visto con videos manipulados con IA de Elon Musk, o Volodímir Zelenski.

Hasta ahora decíamos que los deepfakes no eran aún el problema al no estar al alcance de todo el mundo en internet, pero sí este tipo de cheapfakes. Ahora, una herramienta como Sora con resultados rápidos y más pulidos y perfeccionados puede hacer que sea cada vez más difícil identificar qué es real y qué está realizado con IA. Los detalles en los que nos podíamos fijar se irán quedando obsoletos, igual que ha pasado con las imágenes generadas con IA.

Esto puede suponer un riesgo para la desinformación, como también han señalado otros expertos. Por ejemplo, entre los primeros ejemplos que ha difundido OpenAI para mostrar las capacidades de Sora se encuentran supuestas grabaciones de mamuts, grabaciones históricas de California durante el Salvaje Oeste, imágenes de telediarios y otro tipo de eventos que no han tenido lugar. Unas imágenes que se podrían usar para alimentar teorías de la conspiración o generar imágenes de aspecto histórico que no sucedieron, como ya ha pasado con imágenes creadas con aplicaciones como Midjourney o DALL-E. Aunque no se generen con esa intención, cuando un contenido llega a internet, perdemos el control sobre cómo se comparte.

OpenAI ha señalado que está trabajando con equipos especializados para reducir los peligros para la desinformación que puede suponer esta herramienta y comprobar si se pueden vulnerar las medidas de seguridad de Sora. Sin embargo, la compañía no ha detallado con qué expertos está colaborando.

Factchequeado es un medio de verificación que construye una comunidad hispanohablante para contrarrestar la desinformación en Estados Unidos. ¿Quieres ser parte? Súmate y verifica los contenidos que recibes enviándolos a nuestro WhatsApp +16468736087 o a factchequeado.com/whatsapp.

Lee también: