En Factchequeado hemos verificado deepfakes de políticos, periodistas hispanos e influencers reconocidos. Sin embargo, la mayoría de este contenido que circula en redes consiste en imágenes pornográficas no consensuadas y afecta desproporcionadamente a las mujeres. De hecho, las mujeres constituyen el 99% de las personas víctimas de pornografía deepfake. Así lo indica una investigación de Security Hero, que analizó 95,820 videos deepfake, 85 canales dedicados en plataformas en línea y más de 100 sitios web vinculados al ecosistema deepfake. Estas cifras han sido citadas tanto en testimonios ante el Congreso estadounidense como por organizaciones internacionales como las Naciones Unidas.

La Red Nacional de Violación, Maltrato e Incesto (RAINN, por sus siglas en ingéls) y la Asociación para la Prevención de la Violencia Sexual (SVPA, en inglés) han recibido reportes de víctimas de este tipo de contenido y ratifican que la mayoría de víctimas son mujeres. De hecho, muchas herramientas deepfake desarrolladas por equipos masculinos ni siquiera están diseñadas para funcionar con imágenes del cuerpo de un hombre, según precisa ONU Mujeres.

“El abuso de imágenes intimas mediante deepfakes es, en realidad, otra forma de abuso sexual, otra forma de violencia de género”, dijo Stefan Turkheimer, vicepresidente de Políticas Publicas de RAINN.

Esta es la primera entrega de la serie “Rostros robados: la amenaza de los ‘deepfakes’ sexuales”. En las próximas notas ofrecemos recursos y orientación para víctimas de este tipo de contenido:

Desde Taylor Swift hasta gente común: los avances en IA aumentan el alcance de las víctimas

Entre los casos de víctimas de alto perfil de estos deepfakes, se encuentran famosas como las cantantes Taylor Swift (en enero de 2025) y Megan Thee Stallion (junio de 2024) o la actriz Scarlett Johanson (en 2018). En México, la creadora de contenido y streamer, Alana Torres, afirmó haber sido víctima de estas manipulaciones y que tomaría acciones legales. Pero también se registran casos de personas no famosas, incluyendo el de estudiantes menores de edad, en distintas partes de Estados Unidos y el mundo.

De los videos analizados en 2023 por Security Hero, el 94 % de las personas que aparecen en pornografía deepfake trabajan en la industria del entretenimiento. Entre ellas, cantantes y actrices surcoreanas constituyen el 53% de los casos y son el grupo más comúnmente atacado.

Omny Miranda Martone, fundadora y directora ejecutiva de SVPA, dijo a Factchequeado que anteriormente se requería una “computadora de alta potencia”, “muchas imágenes” y “mucha habilidad técnica” para crear este tipo de contenido. Por estos motivos, la mayoría de víctimas eran “celebridades porque las personas que hacían esto lo hacían para vender las imágenes en línea o para compartirlas como memes y cosas por el estilo”.

Pero los avances tecnológicos en IA de los últimos dos años han hecho posible que se pueda producir este tipo de contenido “en segundos”, con una sola foto y sin necesidad de habilidad técnica ni aplicaciones o software especializados. Como consecuencia, la creación de este contenido de “personas comunes” se ha “disparado absolutamente”, agregó Martone.

Las herramientas que facilitan su creación han proliferado

Desde 2017, ha habido una proliferación de tecnologías de código abierto que facilitan la creación y difusión de deepfakes, según una investigación publicada en 2025 en la revista Journal of Interpersonal Violence.

Josep Curto, especialista en inteligencia de negocio, analítica de negocio y macrodatos, explica que estas aplicaciones se basan en sistemas de inteligencia artificial generativa, específicamente de imágenes. Según Curto, funcionan mediante un algoritmo entrenado con una gran cantidad de imágenes y combinado con una aplicación web o móvil, de manera que la entrada es una imagen y la salida otra imagen a la que se le aplica una transformación, en este caso, generando un desnudo.

Una de las páginas web más conocidas era Mr. DeepFakes, el sitio de pornografia de deepfakes no consensuados más grande del mundo, que recibía millones de visitas al mes. El sitio anunció su cierre después de que uno de sus proveedores de servicios retirara su apoyo en mayo de 2025. Mr. DeepFakes se promovía como un sitio para deepfakes de celebridades, pero también se reportó la creación de contenido de personas que no lo eran.

En la encuesta de Thorn, muchos jóvenes identificaron aplicaciones específicas para la creación de estos deepfakes y también tecnologías de uso general, como herramientas de edición (Photoshop, Canva) o plataformas donde se comparten imágenes (Snapchat, OnlyFans, Pornhub).

Entre el subgrupo que admitió haber creado deepfake de desnudos (nudes) de otras personas, la mayoría describió un acceso sencillo a estas tecnologías. El 70% señaló que usó una aplicación que descargó directamente en la tienda oficial de su dispositivo (App Store o Play Store). Aproximadamente uno de cada tres creadores (30%) indicó que no necesitó descargar nada, porque utilizó herramientas accesibles directamente en línea.

Maldita.es, medio cofundador de Factchequeado, investigó la creación con IA de imágenes de niñas y adolescentes sexualizadas. Analizaron más de 20 cuentas de TikTok que publican videos en los que las menores generadas con IA llevan, en su mayoría, bikinis, uniformes escolares o ropa ajustada. Algunas de estas cuentas redirigen a los usuarios a otros sitios web donde venden pornografía infantil creada con inteligencia artificial. La mayoría de contenidos no mostraban marcas de agua visibles que indicaran con qué herramientas fueron creados.

Qué dicen las leyes sobre estos deepfakes en Estados Unidos

A nivel federal, la ley Take It Down Act, promulgada por el presidente Donald Trump el 19 de mayo de 2025, “combate la difusión en línea de imágenes íntimas no consentidas (NCII)”. Esta ley hace un crimen federal el compartir o amenazar compartir este tipo de imágenes –incluyendo las deepfakes– y requiere que las páginas web y compañías de redes sociales retiren el material en un periodo de 48 horas después de un reporte de la víctima. La prohibición penal de la ley entró en vigor de inmediato pero las plataformas tienen hasta el 19 de mayo de 2026 para establecer el proceso de notificación y eliminación requerido.

Martone califica el Take It Down Act como “un gran primer paso”, pero dijo que la SVPA aboga por la promulgación de otras 2 leyes: una que proteja a los denunciantes (whistleblowers) de irregularidades en el ámbito de la IA y otra que permita a las víctimas demandar a los perpetradores “para reclamar una indemnización por daños y perjuicios”.

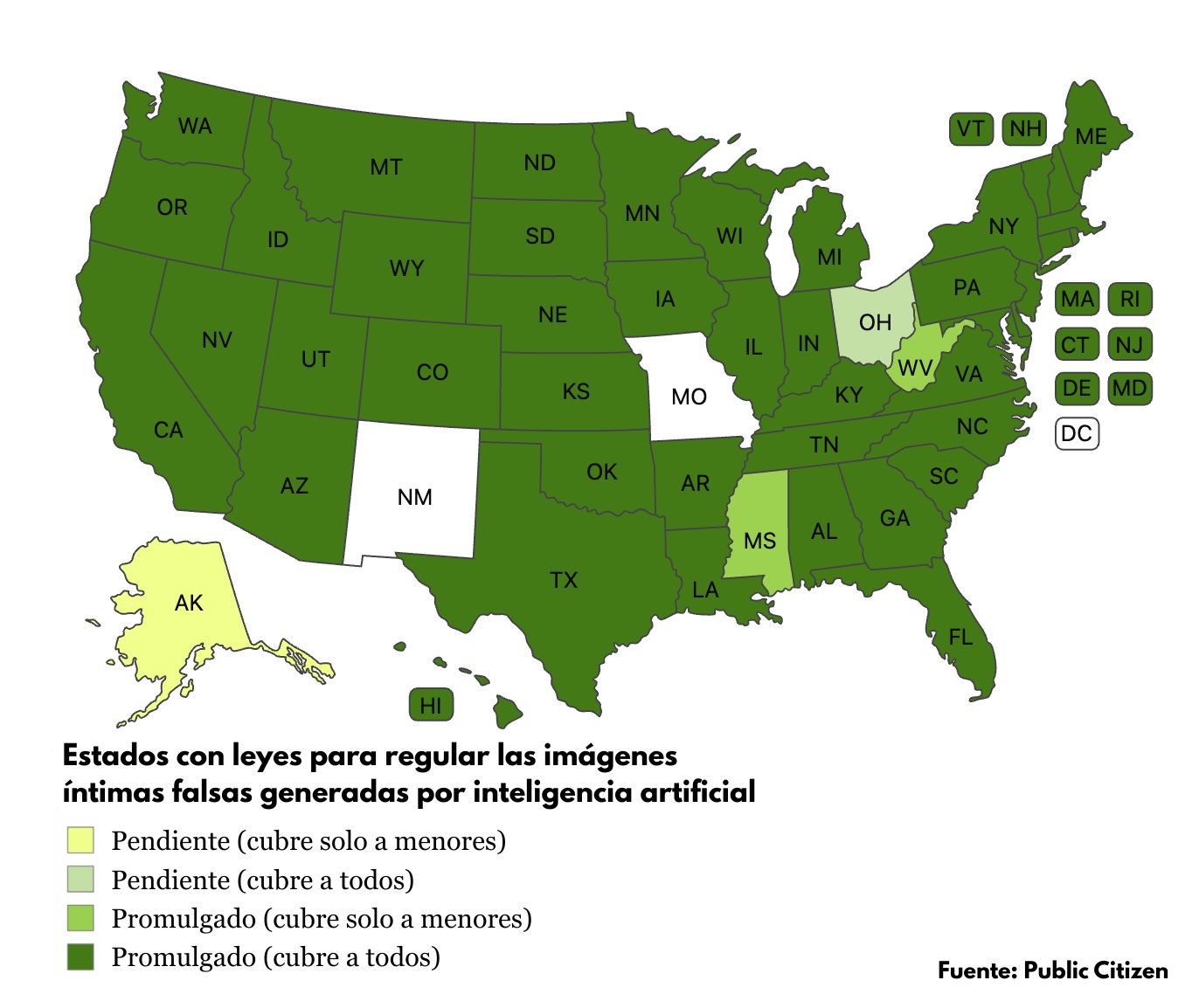

La mayoría de estados en Estados Unidos tienen leyes que abordan o regulan las deepfakes íntimas no consensuadas para todos los usuarios, incluyendo a menores de edad, “usualmente con apoyo bipartidista”, según un análisis realizado por la organización Public Citizen hasta el 20 de octubre de 2025.

Solo Missouri, Nuevo México y el Distrito de Columbia no han pasado legislaciones que regulan estos deepfakes; Ohio y Alaska han presentado proyectos de ley; Mississippi y Virginia Occidental tienen leyes que protegen a menores.

Texas promulgó 2 proyectos de ley en junio de 2025 que regulan los deepfakes íntimos, incluyendo el primero en el país “que responsabiliza civilmente a las plataformas por no proteger a los menores de este tipo de contenido”, según Public Citizen.

J.B. Brach, defensor de políticas tecnológicas de Public Citizen, dijo a Factchequeado que la “esencia de las leyes estatales” es que “se centran en la conducta delictiva y en proporcionar vías para que las personas rindan cuentas por sus acciones”.

El 11 de diciembre de 2025, el presidente Donald Trump firmó una orden ejecutiva que da la autoridad al Fiscal General para “impugnar las leyes estatales sobre inteligencia artificial que sean inconstitucionales, que contravengan la legislación federal o que sean ilegales por cualquier otro motivo y que perjudiquen la innovación”, entre otras cosas. “La regulación estado por estado crea, por definición, un mosaico de 50 regímenes regulatorios diferentes que dificulta el cumplimiento de las normas, especialmente para las empresas emergentes”, dice parte del texto de la orden ejecutiva.

Antes del anuncio de la orden ejecutiva, Martone dijo a Factchequeado que “la Casa Blanca ha estado intentando aprobar una moratoria sobre la IA” para prohibir la implementación o aprobación de leyes estatales relacionadas con la IA, incluyendo las que regulan la pornografía.

Un análisis del Brennan Center for Justice sugiere que esta orden “parece tener como objetivo intimidar a los estados para que desistan de promulgar y aplicar leyes que protejan a los estadounidenses de los perjuicios relacionados con la IA, desde anuncios engañosos hasta deepfakes diseñados para manipular a los votantes, sin que exista una regulación federal que cubra este vacío legal”.

La directiva también instruye al Departamento de Comercio a retener fondos federales a estados que tengan regulaciones estrictas sobre IA y solicita evaluaciones de otras agencias para desalentar la adopción de leyes estatales más fuertes sobre IA, según el Brennan Center.

Turkheimer dijo a Factchequeado que todavía es incierto como la orden ejecutiva se aplicaría o como se va a “decidir qué leyes infringen la orden ejecutiva y cuáles no”. “En definitiva, la situación es bastante incierta en lo que respecta a la aplicación de la ley a nivel estatal en relación con las imágenes íntimas”, agregó Turkheimer.

Factchequeado es un medio de verificación que construye una comunidad hispanohablante para contrarrestar la desinformación en Estados Unidos. ¿Quieres ser parte? Súmate y verifica los contenidos que recibes enviándolos a nuestro WhatsApp +16468736087 o a factchequeado.com/whatsapp.

Lee también: